想象一下,你的辛苦搭建的网站因为搜索引擎无法正确抓取而丢失了大量潜在流量,这是多么令人沮丧的事情!其实,解决这个问题的关键在于一个小文件——robots协议。今天我们就来聊聊如何查看网站的robots协议,以及如何正确设定它,让你的网站更好地适应搜索引擎规则。

什么是robots协议?

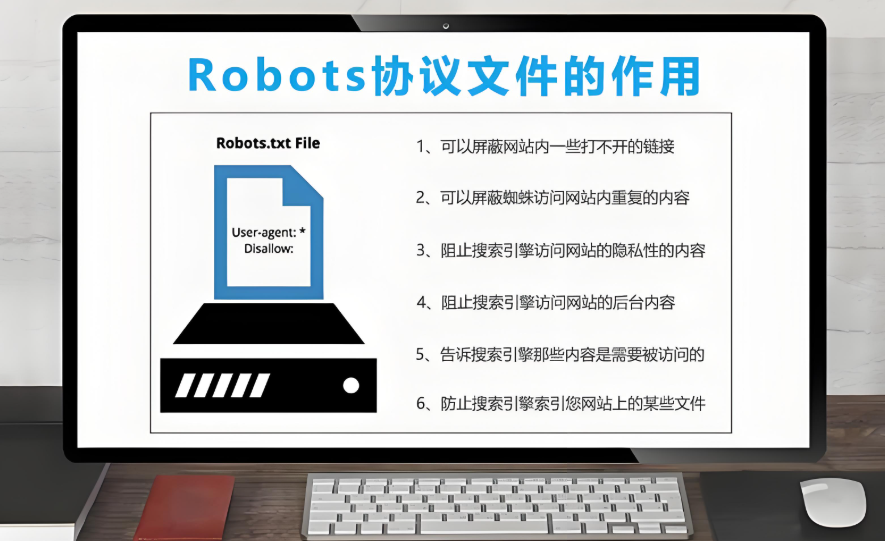

简单来说,robots协议是一个叫做robots.txt的小文件,位于网站的根目录中。它用于告诉搜索引擎抓取机器人(如百度,360,搜狗,今日头条)等搜索引擎的网站上的哪些页面可以抓取,哪些页面应禁止访问。合理设置robots协议不仅可以提高网站的SEO表现,还能保护特定内容的隐私。

如何查看网站的robots协议?

查看robots协议非常简单,你只需要在浏览器的地址栏输入:`http://7ov.cn/robots.txt`(将7ov.cn替换为实际的域名)。如果你的站点正确配置了robots.txt文件,页面会直接显示其中的内容。

此外,你也可以通过Google Search Console或其他站点管理工具进一步检查robots.txt文件是否存在问题。这些工具能够帮助你发现语法错误或无效的规则,从而优化配置。

网站如何正确设定robots协议?

设定合理的robots协议是提升网站SEO的重要步骤。以下是一些实用建议:

1. 明确允许与禁止的内容:

- 使用`User-agent`声明:指定搜索引擎的抓取机器人(如百度,360,搜狗,今日头条)。

- 使用`Disallow`声明:禁止抓取某些页面或目录,例如“Disallow: /PRivate/”。

- 使用`Allow`声明:明确允许抓取的页面。

2. 小心处理重要目录和文件:

不要轻易禁止像网站首页这样的核心页面,否则可能导致搜索引擎无法索引重要内容。

3. 结合sitemap文件:

在robots.txt中添加你的站点地图路径,比如:`Sitemap: http://7ov.cn/sitemap.xml`。这能帮助搜索引擎更快发现你的内容。

4. 定期更新文件:

网站结构变化时,记得及时更新robots.txt以防止错误引导。

互动时间

你是否曾遇到过因为robots协议设置错误而导致网站流量下降的情况?或者对设置robots协议有其他理解?欢迎在评论区留言,我们一起交流经验吧!

优化你的robots协议是迈向高效SEO的重要一步,别忽视小文件的大作用!

标签:

本文链接:https://www.7ov.cn/xinwendongtai/1729.html

版权声明:站内所有文章皆来自网络转载,只供模板演示使用,并无任何其它意义!

下一篇:没有了